近接勾配法 Proximal Gradient Method

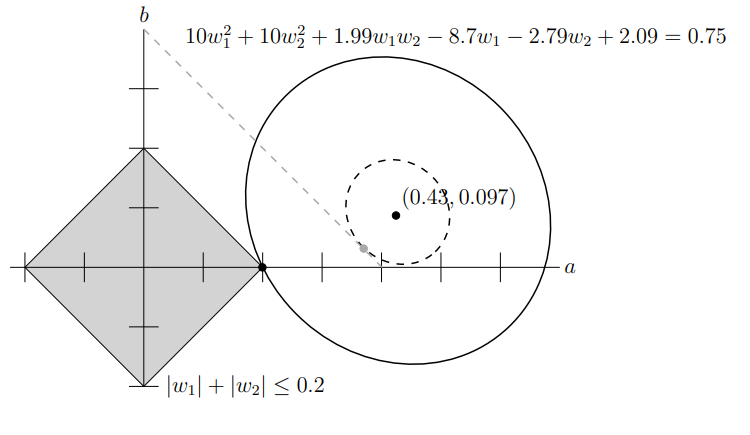

有时候我们的求解的优化问题带有约束,例如当我们希望结果稀疏化时,可以使用 LASSO 来约束目标,即

形式化的说,考虑凸包

此时可以使用近接勾配法 Proximal Gradient Method 进行求解。

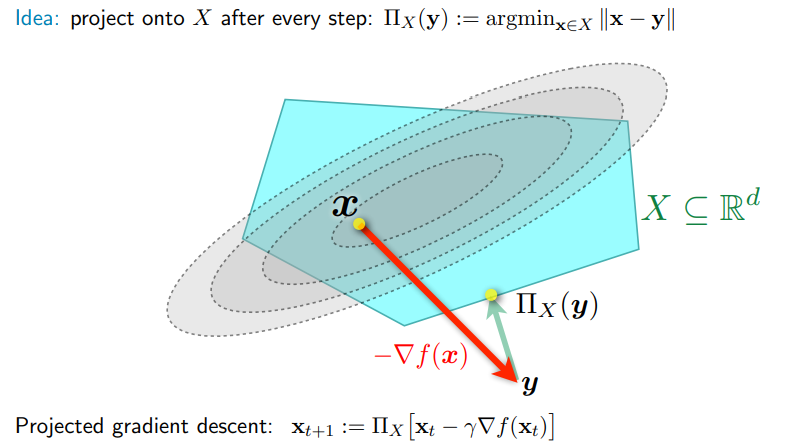

Projected Gradient Descent

Algorithm

求解带凸包约束的凸优化问题,一个直观的想法就是每一步迭代就如梯度下降法一样进行,但是在更新

算法流程如下:

- INPUT: 优化目标

, 凸包约束 , 步长 - S1: 随机初始化解

- S2: 计算梯度

- S3: 梯度下降

- S4: 计算投影

- S5:回到 S2 直到算法收敛

- OUTPUT:

Convergence

事实上,Projected Gradient Descent 算法收敛率和朴素的梯度下降法一致,即

- Lischitz Convex Function:

- Smooth Convex Function:

- Smooth and Strongly Convex Function:

以下给出证明:

我们首先给出两个关于投影的性质,对闭集凸包

利用几何性质容易证明上述结论,这里不再赘述。

Vanilla Analysis

不失一般性,这里首先给出 Vanilla Analysis 收敛性的证明。

将

利用

利用投影性质 2,由

代回,有

利用凸函数性质,求和得到平均误差上界

接下来利用投影的两个性质容易证明几种 assumption 下的收敛性,此处不再赘述。

然而,在实际计算时,计算投影同样被视为对 Oracle 的一次查询,可能会非常耗时。仍考虑 LASSO 的 L1 norm 限制,在

Proximal Gradient Descent

Composite Optimization Problems

考虑目标函数

其中

其中

现在考虑如何优化。如果只考虑性质良好的

现在对于

则得到了 Proximal Gradient Descent 的更新公式,即

其中

当

Convergence

收敛性可以参考 Yurri Nesterov。

收敛性证明和普通情形下相似,唯一需要注意的是新加入的

考虑凸函数

则有

以下给出证明。由 Proximal Gradient Descent 的更新公式,有

由凸性,有

代入上式,有

原先

由

代入上式,有

由于

继续讨论收敛性,分类讨论之:

当

时,有 ,代入上文最小化目标,有 于是有

此情形下会指数级速度收敛。

当

,代入,有 方便起见,记

,有 即

由于每一步迭代都是在最小化,且候选解包含原位置,因此

单调不增,于是有 对前

项累加,有 因此有

因此收敛性得证。